Stable Diffusionで静止画を生成するのは楽しいけれど、「動く画像」を作れたらもっと面白いと思いませんか?実は2023年11月に登場したStable Video Diffusionを使えば、たった1枚の画像から驚くほど自然な動画を生成できるんです!

でも、「Stable Video Diffusionって何?」「使い方が分からない」「ローカル環境で動かせるの?」と疑問を持つ方も多いはず。この記事では、Stable Video Diffusionの基本から応用まで、初心者でも分かりやすく解説します。無料で使える方法や商用利用の可否についても触れますので、ぜひ最後までご覧ください!

- Stable Video Diffusionとは?

- Stable Video Diffusionの導入方法

- Stable Video Diffusionの使い方

- Stable Video Diffusionの商用利用について

- Stable Video Diffusionと他の動画生成AIの比較

※Stable Diffusionの使い方については、下記記事で詳しく解説しています!

Stable Video Diffusionとは?

Stable Video Diffusionは2023年11月22日に Stability AI から公開された、画像から動画を生成するAI技術です。従来のStable Diffusionが静止画を生成するのに対し、Stable Video Diffusionは入力した1枚の画像を元に、自然な動きのある短い動画を作成します。

主な特徴は以下の通りです。

- 画像1枚から動画を生成: 入力画像をもとに、カメラワークや被写体の動きを自動的に作り出します

- 14フレームと25フレームの2種類のモデル: SVD(14フレーム)とSVD-XT(25フレーム)が用意されています

- さまざまなフレームレート: 3~30fpsの範囲でフレームレートを調整可能

- オープンソース: 研究・非商用利用であれば無料で使用できます

- 複数の使用方法: Google Colabやローカル環境など、様々な方法で利用できます

テキストからの動画生成機能も開発中であり、今後のアップデートに期待が高まっています。

Stable Video Diffusionの導入方法

Stable Video Diffusionを使うには主に2つの方法があります。それぞれのメリット・デメリットと共に解説します。

Google Colabで使う方法

Google Colabを使えば、自分のPCのスペックに関わらず、クラウド上でStable Video Diffusionを動かせます。特に高性能GPUを持っていない方におすすめです。

| メリット | ・自分のPC環境に依存しない ・インストール作業が簡単 ・無料で試せる |

| デメリット | ・無料版では使用時間に制限がある ・接続が切れることがある ・生成に時間がかかることがある |

では、使い方を説明していきます!

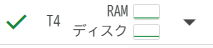

①以下のようなGoogle Colabのデモデータを開きます。

https://colab.research.google.com/github/mkshing/notebooks/blob/main/stable-video-diffusion-img2vid.ipynb②「ドライブにコピー」をクリックして自分のGoogleドライブにコピーします

③ランタイムのタイプをGPUに変更します

- 上メニューの「ランタイム」→「ランタイムのタイプを変更」

- ハードウェアアクセラレータを「GPU」に設定

④すべてのセルを上から順に実行します

- Setup

- Login HuggingFace to download weights(Hugging Faceのアクセストークンが必要)

- Download weights(使いたいモデルを選択)

- Load Model

- Sampling function

- Do the Run!

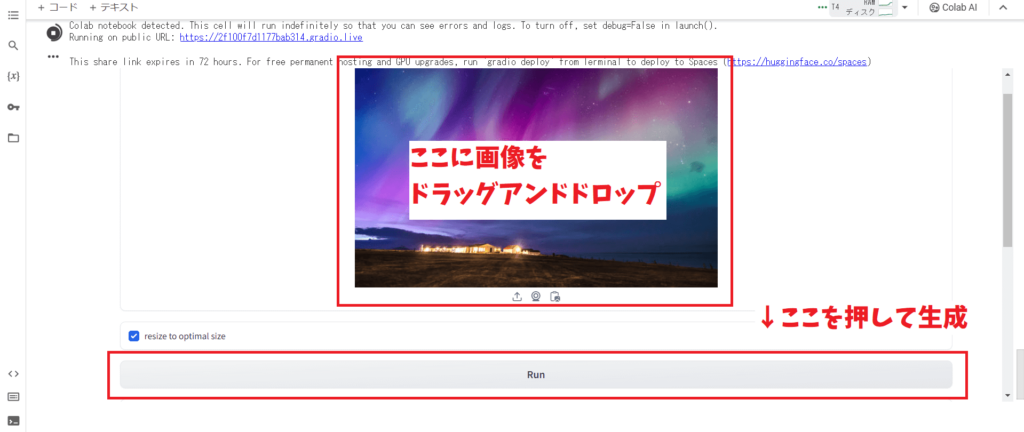

⑤実行が完了すると、画像をアップロードして動画を生成できる画面が表示されます

⑥画像をアップロードして「Run」ボタンを押すと動画が生成されます

ローカル環境にインストールする方法

自分のPCにインストールして使うことで、より自由度の高い環境を構築できます。ただし、それなりのスペックのPCが必要(GPU:VRAM 15GB以上推奨(RTX3090、4090など))です。

| メリット | ・制限なく使用できる ・生成速度が安定している ・カスタマイズの自由度が高い |

| デメリット | ・高スペックのPC(特にGPU)が必要 ・ンストール作業がやや複雑 ・環境構築に時間がかかる |

それでは、ローカル環境へのインストール手順を解説していきます!

- Python: バージョン3.10.6~3.10.11(必ずこの範囲のバージョンを使用)

- Git: 最新版で問題ありません

- 十分なスペックのPC: VRAM 15GB以上のGPUを搭載したPC

- Pythonのインストール

①Pythonの公式サイトからPython 3.10.11をダウンロード

②インストール時に「Add python.exe to PATH」にチェックを入れる

③インストール完了後、コマンドプロンプトで<python –version>と入力して正しくインストールされたか確認

- Gitのインストール

①Git公式サイトから最新版をダウンロード

②インストーラーを実行し、基本的にはデフォルト設定のままでOK

- SVD-webuiのインストール

①インストールしたい場所でターミナルを開く(フォルダを開いて右クリック→「ターミナルで開く」)

②以下のコマンドを実行してリポジトリをクローンgit clone --recurse-submodules https://github.com/sdbds/SVD-webui/

③SVD-webuiフォルダに移動cd SVD-webui

④以下のコマンドを実行git submodule update --recursive --init

⑤インストールスクリプトを実行./install.ps1

- モデルのダウンロード

①Hugging Faceからモデルをダウンロード

svd.safetensors(14フレーム生成用、約9GB)

svd_xt.safetensors(25フレーム生成用、約9GB)

ダウンロードしたモデルをSVD-webui\checkpointsフォルダに配置

- SVD-webuiの起動

①SVD-webuiフォルダ内のrun_gui.ps1を右クリック→「PowerShellで実行」

②ブラウザが自動的に開き、Stable Video DiffusionのWebUIが表示される

これでローカル環境での準備は完了です!

Stable Video Diffusionの使い方

Stable Video Diffusionを使って実際に動画を生成してみましょう。基本的な使い方はとてもシンプルです。

基本的な使い方

①WebUIの画面で「ここに画像をドロップ-または-クリックしてアップロード」に画像をドラッグ&ドロップ

②必要に応じて設定を調整

- resize to optimal size: オンにすると最適なサイズに画像をリサイズします(基本的にはオンで)

- Advanced optionsを開くと以下の設定が可能です。

- number of frames: 生成する動画のフレーム数(モデルによって上限が異なる)

- number of steps: ノイズから画像を生成するステップ数(多いほど精度が上がるが時間がかかる)

- seed: 同じ結果を再現するための値(特定の値を入れると同じ動画が生成される)

- number of frames decoded at a time: 一度に処理するフレーム数(デフォルト値の2推奨)

- frames per second: 動画のフレームレート(5〜30fpsで設定可能)

- motion bucket id: 動きの大きさ(数値が大きいほど動きが大きくなる)

- condition augmentation factor: 元の画像からの変化度(数値が小さいほど元画像に忠実)

③「Run」ボタンをクリック

④生成された動画が表示されるので、ダウンロードボタンから保存

動画生成のコツとポイント

動画を生成する際は、以下の5つのポイントを押さえてみてください!

- 適切な入力画像を選ぶ: 1024×576のサイズが最適(このサイズで学習されている)

- 動きのイメージを持つ: 画像からどう動かしたいかイメージできる画像が良い

- motion bucket idの調整: 値を上げると動きが大きく、下げると控えめになる

- 初めは短いフレーム数から: 生成時間を短縮するため、まずは少ないフレーム数で試す

- seedを記録する: 良い結果が出たら、そのseed値をメモしておく

SVD-XT 1.1の新機能と改善点

2024年2月にリリースされたStable Video Diffusion 1.1(SVD-XT 1.1)では、いくつかの改善が行われました。

SVD-XT 1.1の主な特徴は、以下の通りです。

- ファイルサイズの削減: 1.0では9GB近くあったモデルが1.1では半分の4.5GBに

- 顔の崩れの改善: 1.0で顔が崩れるケースが多かったが、1.1ではその出現率が減少

- 自然な動きの改善: より自然で滑らかな動きを生成できるように

- 生成の安定性向上: 全体的に動画生成の安定性が向上

使用方法は基本的に1.0と同じですが、より高品質な動画が生成できるようになっています。

Stable Video Diffusionで生成できる動画の種類

Stable Video Diffusionでは様々なタイプの動画を生成できます。どのような動画が作れるのか、いくつか例を見てみましょう。

①カメラワークの追加

静止画に対して、ズームイン・ズームアウト・パンニングなどのカメラワークを追加した動画を生成できます。風景写真や建物の写真などに効果的です。

②被写体の動き

人物や動物、乗り物などの被写体に動きを追加できます。例えば:

- 人物が歩いたり、表情を変えたりする動き

- 動物が走ったり、頭を動かしたりする動き

- 乗り物が走行する様子

- 水や煙などの自然現象の動き

③背景の変化

雲の動きや水面のさざ波、木々の揺れなど、背景に微妙な動きを追加できます。

④アニメーション効果

イラストやアート作品に命を吹き込むような動きを追加できます。

Google ColabとローカルでのStable Video Diffusion比較

Google ColabとローカルでのStable Video Diffusionの使用には、それぞれメリット・デメリットがあります。どちらを選ぶべきか比較してみましょう。

| 項目 | Google Colab | ローカル環境 |

|---|---|---|

| 必要なPC環境 | 低スペックでもOK | 高スペックGPUが必要 |

| 初期設定の難易度 | 簡単 | やや複雑 |

| 利用可能時間 | 制限あり | 無制限 |

| 生成速度 | 不安定(混雑状況による) | 安定 |

| カスタマイズ性 | 限定的 | 高い |

| コスト | 無料〜月額課金 | 初期投資のみ |

PCのスペックとコストを考慮して、自分に合った方法を選びましょう。まずは無料のGoogle Colabで試してから、本格的に使いたいならローカル環境を検討するのが良いでしょう。

Stable Video Diffusionの商用利用について

Stable Video Diffusionを商用目的で使用したい場合は、以下の点に注意が必要です。

- 無料版: 研究および非営利目的のみ利用可能

- 有料メンバーシップ: Stability AIのメンバーシッププランに加入すれば商用利用も可能

Stability AIの有料プランについて

2023年12月から開始されたStability AIのメンバーシップには以下のプランがあります。

- 非商用プラン: 個人・研究利用向けの無料プラン

- プロフェッショナルプラン: 月額20ドル、商用利用可能(一定条件あり)

- エンタープライズプラン: カスタム価格、大規模な商用利用向け

プロフェッショナルプランの条件には、以下の条件があるので要注意です※

- 年間収益1億円未満

- 機関投資1億円未満

- 月間アクティブユーザー100万人未満

Stable Video Diffusionと他の動画生成AIの比較

現在、複数の動画生成AI技術が登場しています。Stable Video Diffusionと他のツールを比較してみましょう!

①Stable Video Diffusion vs Runway Gen-2

- Runway Gen-2: テキストから動画を生成できる、UIが直感的、商用利用可能(有料)

- Stable Video Diffusion: 画像から動画を生成、オープンソース、非商用なら無料

②Stable Video Diffusion vs AnimateDiff

- AnimateDiff: Stable Diffusionの拡張機能、低スペックPCでも動作可能、フレーム数少なめ

- Stable Video Diffusion: 独立したモデル、より高品質な動画生成、高スペック要求

③Stable Video Diffusion vs Pika Labs

- Pika Labs: テキストから動画を生成、Discord経由で使用可能、商用利用可(有料プラン)

- Stable Video Diffusion: 画像からの生成に特化、ローカルでも使用可能

それぞれのツールに特徴があるので、用途に応じて使い分けるのがおすすめです!

※それぞれ紹介し滝字もありますので、チェックしてみてください!

【FAQ】Stable Video Diffusionに関するよくある質問

Stable Video Diffusionに関するよくある質問に答えます!

- QStable Video Diffusionを使うにはStable Diffusionが必要ですか?

- A

いいえ、Stable Video Diffusionは独立したツールなので、Stable Diffusionがなくても使用できます。ただし、入力画像を生成するためにStable Diffusionを使うと便利です。

- QVRAMはどうやって確認すればよいですか?

- A

Windowsの場合、タスクマネージャー(Ctrl+Alt+Delete)→「パフォーマンス」タブ→GPUで、専用GPUメモリを確認できます。Macの場合は「このMacについて」→「グラフィック」で確認できます。

- QGoogle Colabでエラーになりました

- A

以下の点を確認してください。

- デモのコードを自分のドライブにコピーしているか

- セルを上から順に実行しているか

- Hugging Faceにログインしているか

- ランタイムのセッションを再起動したか

- Colabのリソースが不足していないか

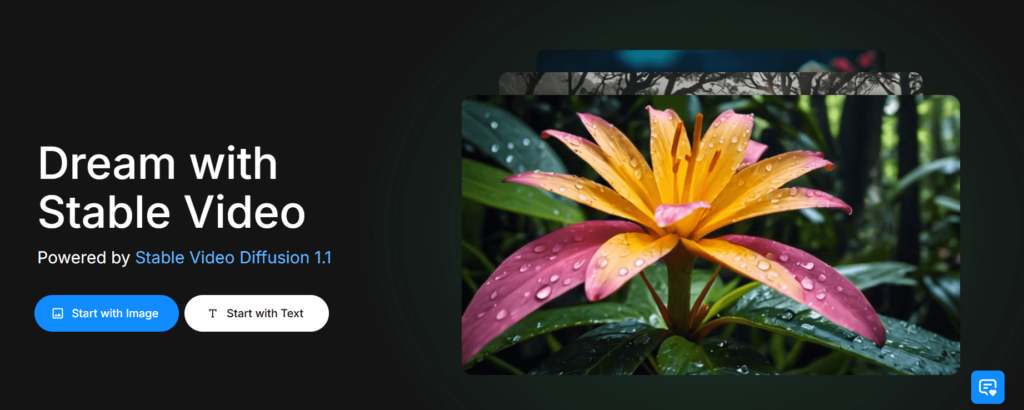

- Qもっと簡単にStable Video Diffusionを試す方法はありませんか?

- A

「Stable Video」というWebサービスを利用すれば、ブラウザから簡単にStable Video Diffusionを試せます。毎日無料クレジットが付与されるので、気軽に試すのに適しています。

- Qローカル環境での動画生成が遅いのですが、改善方法はありますか?

- A

以下の方法で改善できる可能性があります。

- フレーム数を減らす

- ステップ数を減らす

- 解像度を下げる

- GPUのドライバーを最新版に更新する

- 他のアプリケーションを閉じてリソースを確保する

まとめ

いかがでしたでしょうか?

Stable Video Diffusionの概要から使い方、ローカル環境の構築方法、商用利用の注意点まで詳しくご紹介しました。

この記事で紹介したことをまとめると次のようになります。

- Stable Video Diffusionは画像1枚から自然な動画を生成できるAIツール

- Google Colabを使えば低スペックPCでも使用可能、ローカル環境なら高品質の動画が安定して生成できる

- 動画生成は基本的に画像をアップロードして「Run」ボタンを押すだけというシンプルな操作

- 商用利用の場合はStability AIのメンバーシッププランへの加入が必要

- SVD-XT 1.1では顔の崩れが少なくなるなど、品質が向上している

AI動画生成に興味を持っていた方や、Stable Diffusionユーザーで動画も作ってみたいと思っていた方に、かなり助けになる情報だったのではないでしょうか?

ぜひ、皆さんも1枚の画像から動く世界を創造する、Stable Video Diffusionを試してみてください!