Claudeは、『Anthropic(アンソロピック)』が運営する対話型の生成AIです。質疑応答や文章生成・要約などの基本的な出力に加え、長文理解やプログラミングコード生成なども優れています。

この特徴により多方面から大きな支持を得ているClaudeに関して、今回は下記の内容を解説します。

- Claudeが採用している「憲法AI」について

- Claudeが実施している安全対策

- 会話を学習データとして使用するかの選択

- Anthropicがどのような企業か

本記事を読めば、Claudeの安全性に関する不安が解決するため、使用を検討している方はぜひ参考にしてください。

📖この記事のポイント

- Claudeは独自の『憲法AI』により高い安全性を誇る

- データの暗号化や違反ユーザーへの対応など、数々の安全対策を備える

- 運営企業『Anthropic』の創始メンバーは、AIのプロフェッショナル集団

- AIやセキュリティについてさらに学びたいのなら、専門セミナーへの参加がおすすめ

- たった2時間の無料セミナーで会社に依存しない働き方&AIスキルを身につけられる!

- 今すぐ申し込めば、すぐに月収10万円UPを目指すための超有料級の12大特典も無料でもらえる!

\ 累計受講者10万人突破 /

無料特典を今すぐ受け取るClaudeは安全性確保のために「憲法AI」を採用

Claudeは、数ある対話型AIのなかでも、とくに安全性が高い評価を受けています。その理由は、開発会社であるAnthropicが採用している『憲法AI』です。

ここでは、Claude特有の仕組みである憲法AIについてご紹介します。

人間のフィードバックに依存せず、AIが自ら学習を進める手法

憲法AIとは、特定のルールに従い善悪を判断し、安全性を高めているAIのことです。この「ルール」は特性上「憲法」と呼ばれ、AIの思考や動作を決める方針として役立ちます。

Claudeにおける憲法(ルール)は、以下の通りです。

- 最も危険性や憎悪度の低い応答を選択してください。

- できるだけ信頼性が高く、正直で、真実に近い回答を選択してください。

- 明確な意図を最もよく伝える応答を選択してください。

上記の憲法により、Claudeは人間のフィードバックに依存せず、自らの出力内容を評価・修正して学習することが可能です。

憲法AIの利点は「より信頼性の高いAIの実現」

憲法AIの利点は、攻撃的な表現や誤情報の出力を自らの判断で避け、プロンプトインジェクションのリスクを低減できることです。

Claudeは憲法AIに基づき、ユーザーのプロンプトに影響されることなく、一貫性のある学習を行えます。

過去にはプロンプトインジェクションにより、企業顧客の個人情報が流出するという事件も発生しました。

その事件を受け、Claudeは憲法AIにより、プロンプトインジェクションによる指示を受け付けない仕組みを強化したのです。そのため、悪意ある第三者によるセキュリティ突破を防げるAIといえます。

セキュリティ面は大丈夫?Claudeの安全対策4つ

続いては、Claudeが備えている4つの安全対策の紹介です。セキュリティ対策や有害コンテンツ生成対策に関して、さらに深掘りしていきます。

- 会話の内容を学習に利用するかユーザーが選択可能

- ユーザーごとに暗号化されたIDが割り当てられる

- 規約違反ユーザーへの利用制限

- 有害コンテンツの検出

①会話の内容を学習に利用するかユーザーが選択可能

規約とプライバシーポリシーの改定により、プロンプトや会話の内容を学習に使用するか、ユーザーが選択可能になりました。

詐欺や悪用など有害な使用に対する保護強化とモデルの性能向上が目的です。

今までのClaudeは、基本的にデータが学習に使用されることはないと公式に明言していました。

しかし規約が改定され、ユーザーが自分の意志で、データを学習に使用させるか決められるようになりました。

他の生成AIは、デフォルトで会話内容を学習データとして使用することを許可する機能が有効です。

しかしClaudeは、新規ユーザーはサインイン時に、既存ユーザーはログイン時に利用可否を設定する画面が表示されます。

学習データとしての利用を拒否しても、入力内容は別途保存されるため、流出リスクがゼロではないことに留意しましょう。

詳しくは下記の記事を参考にしてください!

②ユーザーごとに暗号化されたIDが割り当てられる

Claudeのユーザーには、一人ひとりに暗号化されたIDが割り当てられます。

電話番号やメールアドレスを登録する際に、情報はすべて暗号化されます。アカウント管理に関する動作も、IP制限や多要素認証が可能です。

また入力・出力に関するデータもすべて暗号化され、安全な通信経路でやりとりされるため、情報漏洩のリスクが少ない点も利点です。

上記のIDシステムはプライバシーを守り、不適切な利用があった際には追跡できる仕組みとして導入されています。

無料版でも有料版と同一水準のセキュリティが設計されており、ビジネス利用のユーザーも安心して利用できます。

③規約違反ユーザーへの利用制限

Claudeは、規約違反を繰り返すユーザーに対し、利用制限をかける仕組みも導入しています。Anthropicが順守を求める利用ポリシーは下記の通りです。

- 適用法に違反したり違法行為に関与したりしない

- 重要なインフラを危険にさらさない

- コンピュータやネットワークシステムを侵害しない

- 兵器の開発や設計をしない

- 暴力や憎悪行為を扇動しないでください

- プライバシーや個人情報の権利を侵害しない

- 子どもの安全を損なわないでください

- 心理的または感情的に有害なコンテンツを作成しない

- 誤った情報を作成または拡散しない

- 民主的なプロセスを損なったり、標的を絞った選挙活動に従事したりしない

- 刑事司法、検閲、監視、または禁止されている法執行目的に使用しない

- 詐欺、虐待、略奪行為をおこなわない

- 当社のプラットフォームを悪用しない

- 性的に露骨なコンテンツを生成しない

上記ポリシーに違反すると、アクセス制限や停止、出力のブロック等が実施されます。このルールにより、長期的に安心して利用できる環境が整備されています。

Claudeは「倫理的な使用が保証されているAI」であるため、違反者にも厳正な姿勢を維持しているのです。

④有害コンテンツの検出

Claudeは有害コンテンツ生成やプロンプトインジェクションに対して高い安全性を確保しています。その安全性を支えているのが「明確な利用ポリシー」と「憲法AIによる内部学習」です。

とくに『Claude2』モデルのリリース以降は、より精度の高い有害コンテンツ検出モデルが搭載されました。

有害な内容や誤解を招く内容等を自動で検出、対象コンテンツにフラグを立てる形で警告するため、誰もが安心して利用可能です。

AIを使用していると、明確な悪意がない場合でも、気付かないうちにポリシーを違反してしまうケースがあります。

またプロンプト内容が語弊のある形で伝わり、違反行為として認識されてしまう場合もあるでしょう。

そんなとき、Claudeであればまず警告の形で告知し、ユーザーがより慎重な対応を取るように示唆してくれます。

ユーザーが安全に利用できるだけではなく、自らが意図せず危険行為を防げる点も、Claudeの安全性における強みです。

学習データとしての使用に関する変更

2025年8月29日に公表された改定により、会話を学習データとして使用するか、ユーザーが選択する形式になりました。

今までは、フィードバックを送った場合と安全ポリシーに違反した場合を除き、データは学習に使用されませんでした。

しかし、これからはユーザーに選択が委ねられており、9月28日以降の使用では設定が必須です。

(フィードバックを送った場合、安全ポリシーに違反した場合は例外で、設定の可否に関係なく学習に使用される)

変更が適応される対象はClaude Free、Pro、Maxプランを使用しているユーザーです。加えて、対象のプランに紐づけられたアカウントからClaude Codeを使用する場合も含まれます。

しかし、下記の業務利用やAPI使用、商用規約に基づくサービスは適応されないため注意してください。

- チームプランとエンタープライズプランを含むClaude for Work

- Google の API、Amazon Bedrock、または Google Cloud の Vertex API

- Claude Gov と Claude for Education

学習使用可否の設定方法

ここでは、会話を学習データとして使用するか、その設定方法を解説します。

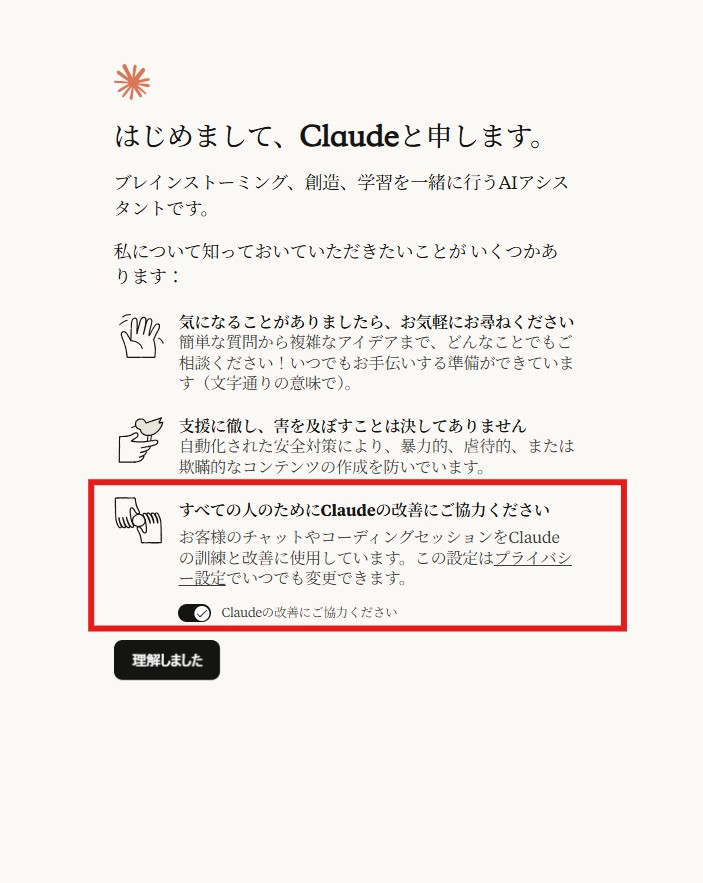

新規ユーザー、既存ユーザー共にサインアップ時やログイン時に画面が表示されるため、そこで設定します。ただしその場で決断する必要はなく、後から変更も可能です。

上記画像は、新規ユーザーがメールアドレスかGoogleアカウントでサインアップした後に表示される画面です。赤枠部分で、許可するかしないかを設定します。

その場で決められない場合は一旦どちらかにしておき、後で変更し直せます。

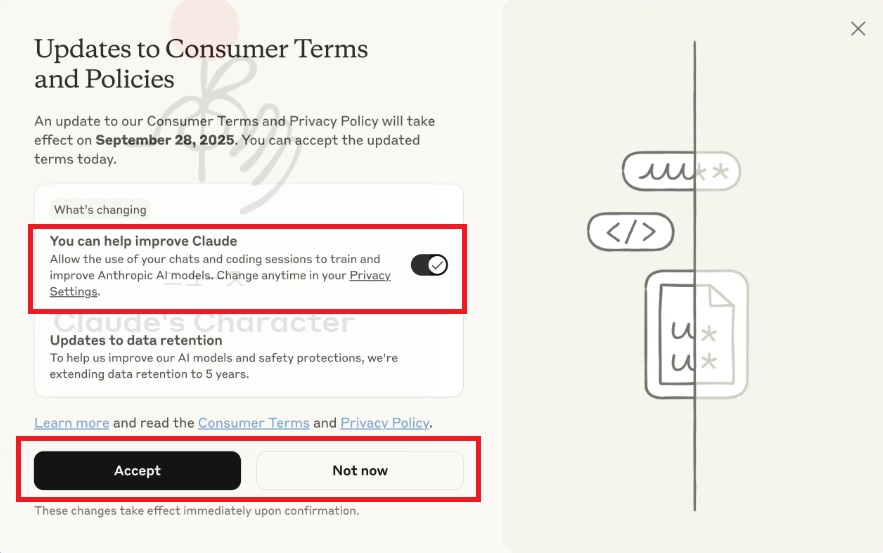

既存ユーザーは、ログインすると上記画像のポップアップが表示されるため、ここで選択してください。「Not Now」を選ぶことで、新規ユーザーと同様に後から設定できます。

以下にて、後で設定する際の方法を説明します。やりかたが簡単なため、後で設定を変えたいと思ったときにすぐ変更できて便利です。

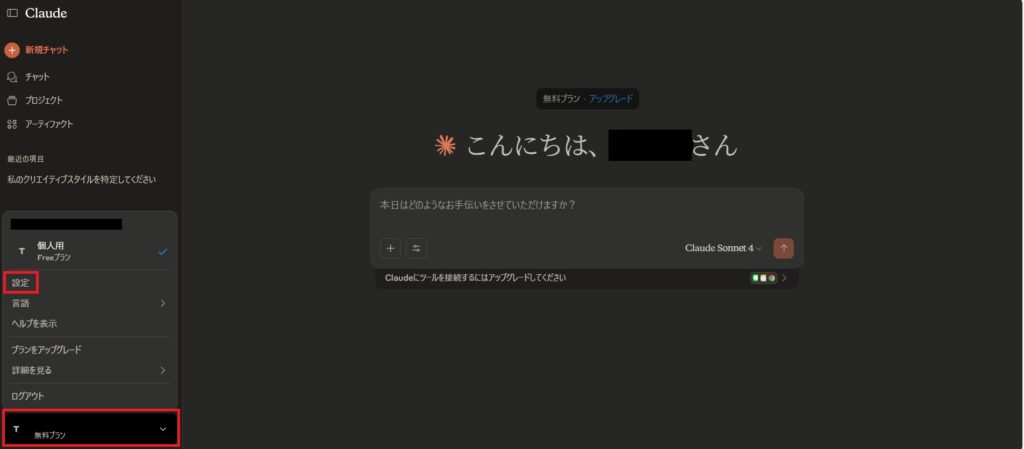

設定は「プライバシー設定」から行います。まずは画面左下のアカウント部分をクリックして「設定」を開いてください。

「プライバシー」を選択し、最下部の赤枠「Claudeの改善にご協力ください」の部分で、許可するかしないかを選びます。これで設定完了です。

学習データとしての使用を許可した場合、新規の会話と再会した会話、コーディングセッションに設定が即座に適応されます。

データ保持期間の延長

もう1つの変更内容が、データ保持期間です。

学習にデータ使用を許可した場合、既存の30日間から5年間に延長されます。対象は新規の会話と再会した会話、コーディングセッションです。

使用を許可しない場合や削除された会話、再開していない会話は延長しないため、保持期間は今までと変わらず30日間です。

学習使用可否の設定の例外であるフィードバックと、ポリシー違反は期間が異なります。ユーザーから提供されたフィードバックに関するデータは5年間保持されます。

ポリシー違反のフラグが立てられた場合の期間は、入力・出力データは最大2年間、信頼と安全性の分類スコアは最長7年間です。

Claudeの運営会社「Anthropic」の安全性

Claudeの運営会社は、2021年に設立されたアメリカのスタートアップ企業「Anthropic」(アンソロピック)です。

ここではAnthropicの企業説明を通し、Claudeを含むサービスの安全性について解説していきます。

OpenAIの元メンバーによって設立された人工知能企業

Anthropicは、ChatGPTの運営会社として著名な『OpenAI』に所属していたメンバーによって設立されました。

OpenAI社のChatGPTは、生成AI市場において圧倒的なシェアを占めている生成AIです。しかし昨今は競合サービスが増えていることから、市場拡大は容易ではありません。

多くの競合他者がいるなかで筆頭に挙げられる企業が、人工知能企業であるAnthropicです。

Anthropicが注目を受ける大きな理由は、今回ご紹介したClaudeシリーズの開発です。

Claudeは、OpenAIのモデルでは対応できない「大量の文章の一括処理」に優れています。そのため、該当するニーズを持つ企業での利用が増加しています。

さらに、AnthropicはAmazonから最大80億ドル、Googleから累計20億ドルもの出資を受けた企業です。これは「AI業界において異例の資金調達の実現」として、大きな注目を集めました。

Anthropicは、名実ともに「AI業界の最先端を突き進む企業」の1つといえるでしょう。

安全性にも関わる「Anthropicの理念」

Anthropicは、安全性と信頼性の高いAI技術を確立するための企業理念を掲げています。その企業理念とは、「人々が信頼できるシステムの構築を目指し、AI研究に専念すること」です。

Anthropicは、人間がAI技術を安心して利用するためには、システムの透明性が重要であると考えています。

例えばAIが「もっともらしい答え」を出力しても、AIの意思決定プロセスが不透明な場合は、回答の真偽が判断できません。

AIが下した判断の理由や経緯などを把握することで、初めて「社会的意義のあるAI活用が実現する」とAnthropicは考えます。

この考えは、Claudeの憲法AIの存在に一貫性を与えています。

ユーザープロンプトに左右されないため、意思決定や出力内容の基準が揺らがず、常に「Claudeの思考として整合性のある回答」が得られるのです。

Anthropicは自社が目指すAI社会のために、利益に関連する研究・開発だけではなく、安全性・信頼性の高いAI技術の提供・確立を目指しています。

Claudeはユーザーの安全面に配慮された生成AI

本記事では、Claudeの利用における安全性について解説しました。

要点をまとめると、以下の通りです。

- Claudeは、独自の『憲法AI』に基づき高い安全性を確保している

- 明確なポリシーやデータ暗号化などにより、長期的な安全性が期待できる

- 運営会社は、AmazonやGoogleからも出資を受ける注目のスタートアップ企業

Claudeと他の対話型AIサービスとの大きな違いは2つあります。

1つは、会話の内容を学習に使用するかユーザーに選択肢が委ねられており、データの取扱いが透明であることです。もう1つは、徹底したポリシーによる違反者への対応です。

またデータの暗号化によりユーザーのプライバシーが守られるのも大きな魅力といえます。ぜひこの機会に、十分な安全性が担保された生成AIであるClaudeを利用してみてはいかがでしょうか。

romptn ai厳選のおすすめ無料AIセミナーでは、AIの勉強法に不安を感じている方に向けた内容でオンラインセミナーを開催しています。

AIを使った副業の始め方や、収入を得るまでのロードマップについて解説しているほか、受講者の方には、ここでしか手に入らないおすすめのプロンプト集などの特典もプレゼント中です。

AIについて効率的に学ぶ方法や、業務での活用に関心がある方は、ぜひご参加ください。

\累計受講者10万人突破/