「Stable Diffusion WebUI Forgeで、新しい画像生成を始めてみませんか?」

この記事では、高機能で高速に画像を生成する「Stable Diffusion WebUI Forge」についてを詳しく解説しています。

実際にどれほど速く、どれほど綺麗に画像を生成できるのか、その効果を直接体験してみてください!

Stable Diffusion WebUI Forgeとは?

Stable Diffusion WebUI Forgeは、画像生成AIです。

プログラミング不要で、簡単なAI画像生成が利用できます。

特にGoogle Chromeなどの主要ブラウザで動作し、誰でも手軽に高品質な画像を生成できます!

Stable Diffusion WebUI Forgは、ControlNetの開発者であるLvmin Zhang氏が開発したユーザーインターフェースであり、広く使われている「Stable Diffusion web UI(AUTOMATIC1111版)」と比較して画像を高速に生成できるという特長があります。

実際にStable Diffusion WebUI Forgeをインストールする手順や、AUTOMATIC1111版との生成速度の差を確認することで、その効果を体験可能です!

Stable Diffusion WebUI Forgeに必要なスペック

Stable Diffusion WebUI Forgeを使用するためには、以下のスペックが必要です。

- CPU: 8コア

- メモリ(RAM): 32GB

- GPU: NVIDIA A4000

- GPUメモリ: 16GB

- SSD: 1TB

これらのスペックにより、画像生成の速度が向上し、VRAM使用量が削減されます。

Stable Diffusion WebUI Forgeは特にVRAMが少ないGPUで大きな効果を発揮します。

例えば、VRAM 6GBでは画像生成速度が約60~75%向上し、使用量を最大1.5GB削減できます!

Stable Diffusion WebUI Forgeの導入方法

Stable Diffusion WebUI Forgeのをインストールする方法は2つあります。

それぞれ詳しく解説していきましょう!

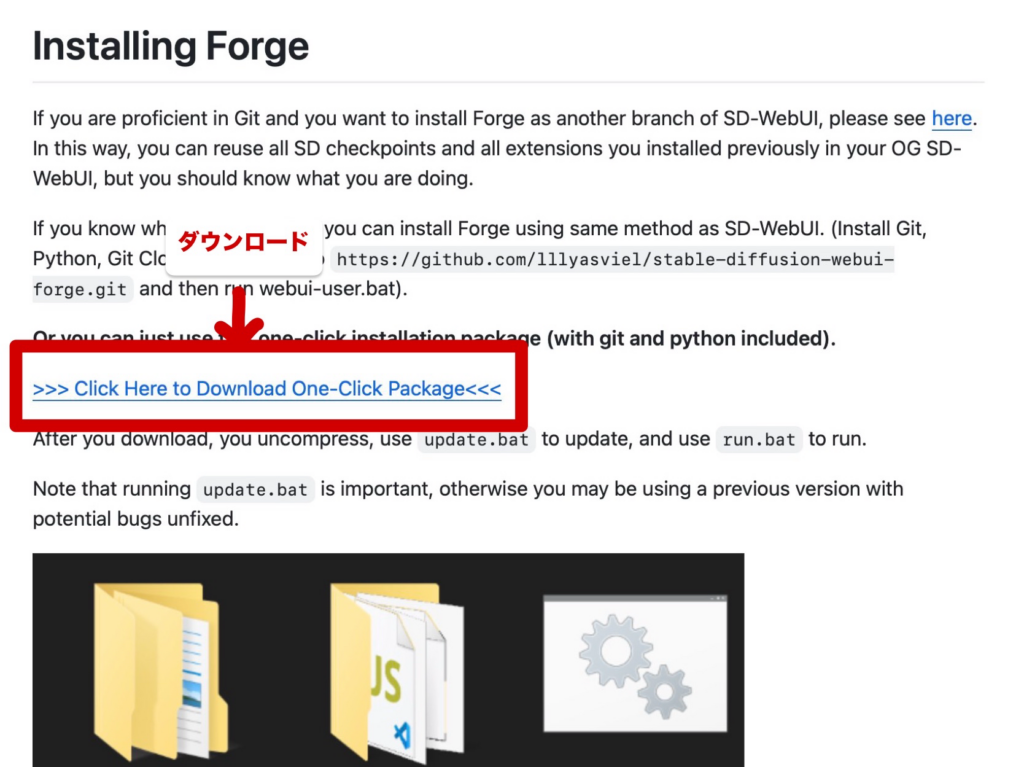

方法①:圧縮ファイルをダウンロードして利用する

GitHubのページ上で提供されている圧縮ファイルをダウンロードすることでStable Diffusion WebUI Forgeをローカル環境で使用することができます!

手順は以下の通りです。

- GitHubから圧縮ファイルをダウンロードする

- ダウンロードした圧縮ファイルを解凍する

- ファイルが解凍されたら、「update.bat」を開く

- 次に「run.bat」を開くと、Stable Diffusion WebUI Forgeが起動します。

ファイルのダウンロードは以下のページから行いましょう!

方法②:GitHubリポジトリをクローンする

次に、コマンドプロンプトで以下を実行して、公式のリポジトリをクローンしましょう。

下記のコードを順に実行すれば、Stable Diffusion WebUI Forgeを起動できます!

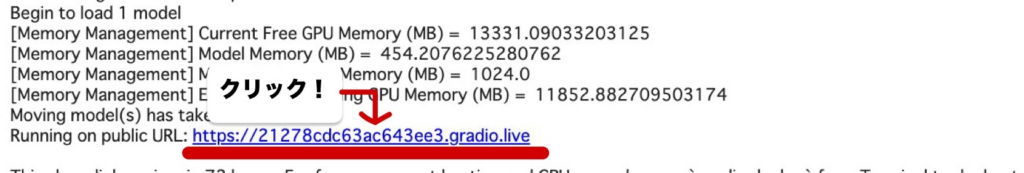

1. Stable Diffusion WebUI ForkのリポジトリをGoogle Colabに複製します。

!git clone https://github.com/lllyasviel/stable-diffusion-webui-forge.git2. ディレクトリを移動した後に、Stable Diffusion WebUI Forgeのインストールおよび起動をします。

%cd /content/stable-diffusion-webui-forge

!python launch.py --share --enable-insecure-extension-access3. インストールが次第、下記画像のURLを開けばStable Diffusion WebUI Forgeの画面が表示されます。

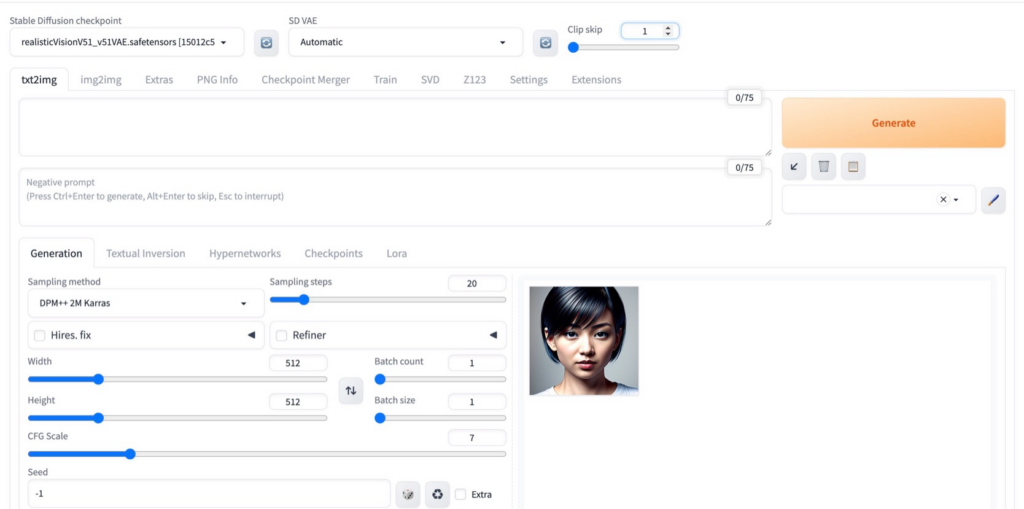

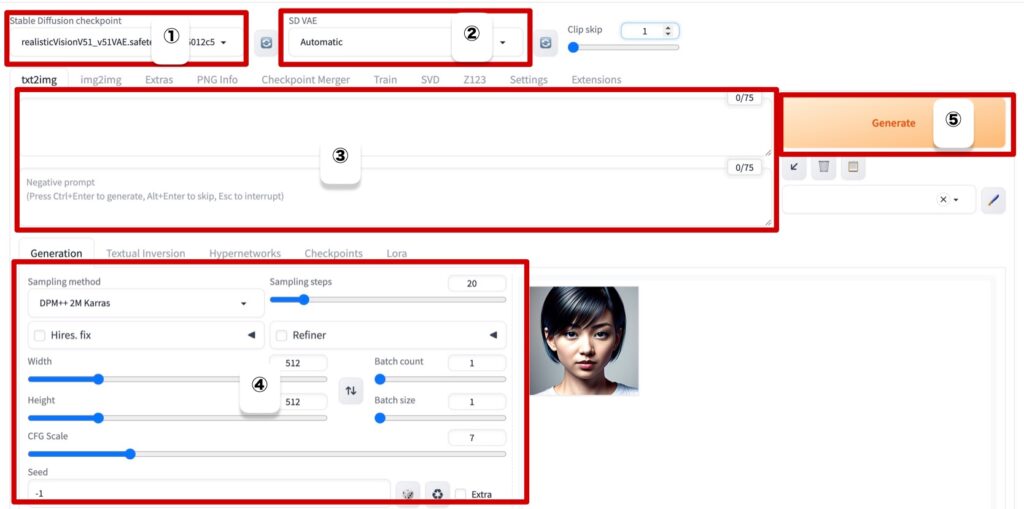

Stable Diffusion WebUI Forgeの画面

Stable Diffusion WebUI Forgeの使い方

それでは、ここからは、Stable Diffusion WebUI Forgeの使い方を解説していきます。

基本は以下の項目設定すれば画像が生成できます!

- 画像生成モデル

- VAE

- プロンプト&ネガティブプロンプト入力欄

- 各種パロメータ

- 生成「Genarate」ボタン

Stable Diffusion WebUI Forgeは新技術であるものの、従来のStable Diffusion Web UI(AUTOMATIC1111版) の使い方と大きく違いはありません!

そのため、大きく変わったポイントだけご紹介します。

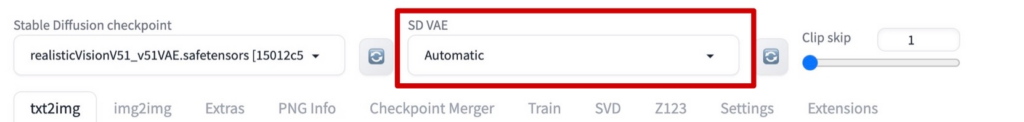

1. 初めからVAE欄が導入されている

AUTOMATIC1111版ではVAEはあとから自分でインストールし、選択項目を設ける必要がありました。

しかし、Forge版では初めから選択項目が設けられているます!

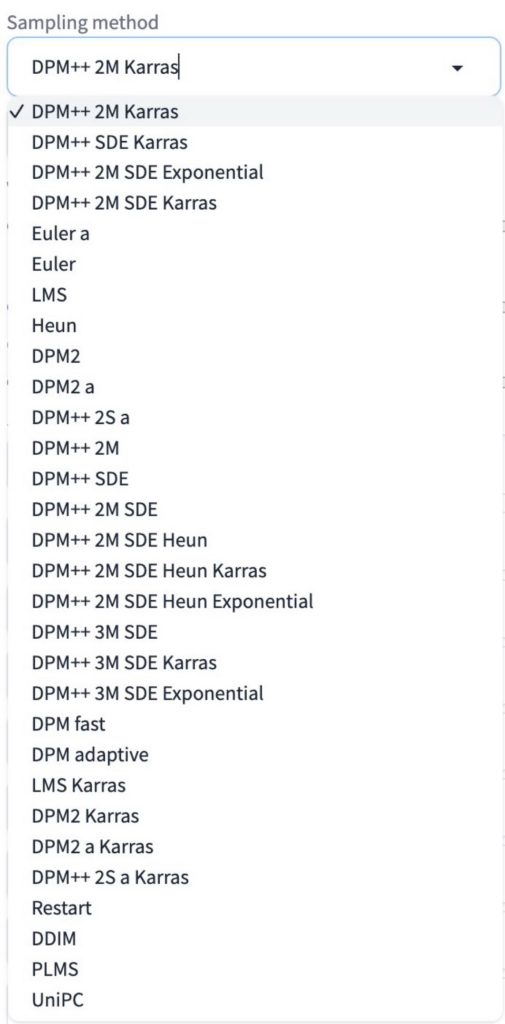

2. サンプラーがAUTOMATIC1111版よりも豊富

Forge版では選べるサンプラー数が増えています。

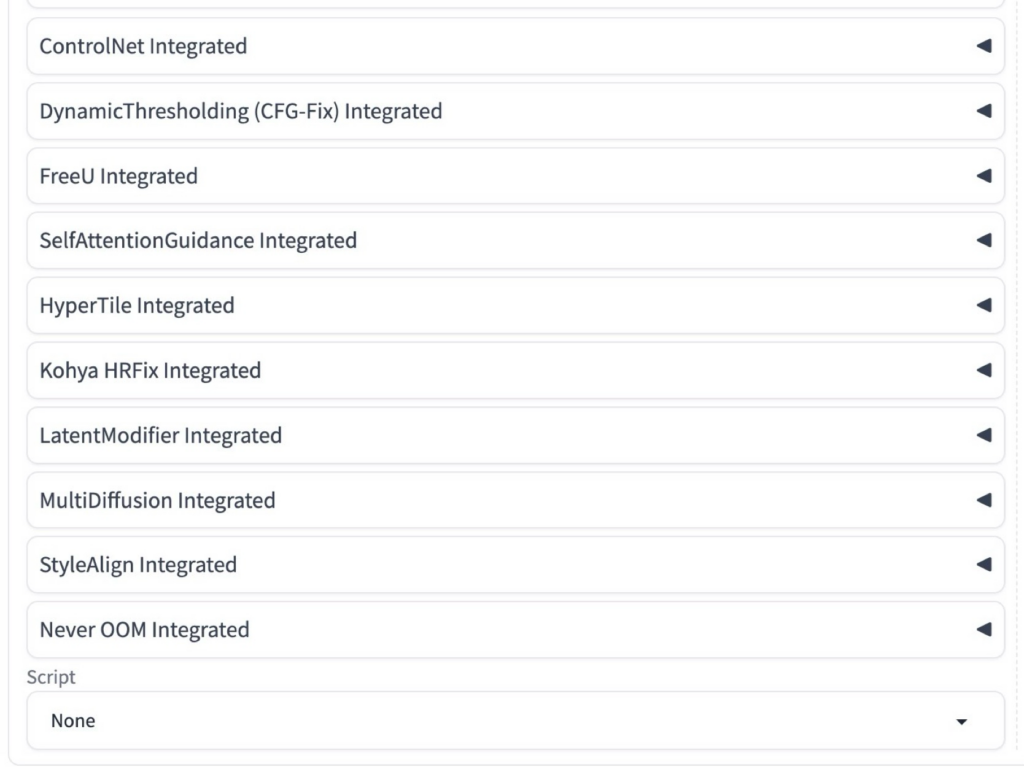

3. デフォルトで拡張機能が追加されている

ControlNetなど人気の拡張機能がデフォルトで備わっています。

※「Stable Diffusion」の基本操作については以下の記事で詳しく解説しています!

参考記事:https://weel.co.jp/media/tech/stable-diffusion-webui-forge

【活用術】Stable Diffusion WebUI ForgeでLoRAを導入する方法

LoRAとは、「Low-Rank-Adaptation」の略称で、AIの追加学習を驚くほど少ない計算資源で可能にする技術です。

Stable Diffusion WebUI ForgeでもLoRA使うことが可能です!

LoRAの導入は以下の手順で行います。

LoRAの導入手順

- CivitaiまたはHugging FaceからLoRAモデルをダウンロードします。

- ダウンロードしたLoRAモデルファイルを「stable-diffusion-webui」→「models」→「LoRA」に保存する。

- Stable Diffusion WebUI Forgeで、使用するLoRAモデルを選択します。

※LoRAについての詳しい概要は、以下の記事で解説しています。

Stable Diffusion WebUI Forgeで使える便利な拡張機能

Stable Diffusion WebUI Forgはデフォルトでも画像生成の技術が向上しています。

さらに、拡張機能を使用すれば、さらに画像生成が向上します!

今回は以下のおすすめ拡張機能3選をご紹介します。

①ADetailer

ADetailerは、生成された人物やキャラクターの顔のパーツ、表情、手などの細部を編集可能な拡張機能です。

ADetailerを使用することで、すでに生成されている画像に対して細かな修正を行い、全体の印象を崩さずに改善することができます。

特に、プロンプトを大きく変更すると全く異なる人物やキャラクターが生成されてしまう問題を避けたい場合に役立ちます。

ADetailer使用前(左)&ADetailer使用後(右)

※ADetailerについての詳しい概要は、以下の記事で解説しています。

②Config-Presets

Config-PresetsはStable Diffusion WebUI Forgeで各種設定パラメーターの数値を保存できるようになる拡張機能です。

ControlNetやFreeUなどの設定値を記録しておくことで、一度生成した高品質な画像を再現しやすくなります。

Config-Presetは、画像生成時に細かいパラメーター調整を頻繁に行うユーザーにとって特に便利で、手間のかかるメモ取りを省くことができます。

※Config-Presetsについての詳しい概要は、以下の記事で解説しています。

③FreeU Integrated

FreeU Integratedは、画質調整を簡単に行うことができる拡張機能です。

B1, B2, S1, S2という4つのパラメーターを利用します。

FreeU Integratedを有効にし、これらのパラメーターを調整することで、生成される画像に直接変更を加えることができます。

FreeU Integrated使用前(左)&FreeU Integrated使用後(右)

Stable Diffusion WebUI Forgeは商用利用可能?

Stable Diffusion WebUI Forgeは、GNU Affero General Public License v3.0 (AGPL-3.0) のもとで公開されています。

商用利用を含む多くの使用権を許可していますが、いくつかの条件が付いています!

| 用途 | 利用 |

|---|---|

| 商用利用 | ○ |

| 改変 | ○ |

| 配布 | ○ |

AGPL-3.0は、他の多くのオープンソースライセンスと比べて使用にあたって厳格なルールが設けています。

商用利用を考えている場合、条件を守ることで自由に使用することが可能です!

Stable Diffusion WebUI Forgeを商用利用にあたってはライセンスの全条項を理解し、遵守することが重要です!

もっと詳しく知りたい方は、下記のGitHubページをご確認ください。

まとめ

いかがでしたでしょうか?

超高機能画像生成モデル「Stable Diffusion WebUI Forge」について解説してきました。

今回のポイントをまとめると、以下のようになります。

- 使用には8コアのCPU、32GBのRAM、NVIDIA A4000 GPU、16GBのGPUメモリ、1TBのSSDなど高いスペック必要です。

- GitHubから圧縮ファイルをダウンロードし、簡単な手順でインストール可能です。

- ControlNetの拡張機能が初期から利用でき、より高度な画像生成が行えます。

Stable Diffusion WebUI Forge使うことにより、従来のstable diffusionよりも効率的に画像生成が可能になります。

この記事が少しでもみなさんの活動の助けになれば幸いです。

また、生成AIに関する更なる情報は、他の記事にて詳細に解説していますので、そちらの内容もぜひ確認してみてください!