中国のスタートアップ企業DeepSeekが、画像生成AIモデル「Janus-Pro」(ヤヌス プロ)を発表し、大きな注目を集めています。

このモデルは軽量でありながら非常に高性能で、次世代のAIモデルとして注目が集まっています。

本記事では、Janus-Proの特徴や他モデルとの比較、実際に試してみた結果をご紹介します。

先んじて発表されている、NVIDAの株価暴落を引き起こした話題のAI、DeepSeek R1について知りたい方は以下の記事をご覧ください。

Janus-Proの特徴と種類

DeepSeek AIによって開発されたJanus-Proは、高度なマルチモーダル大規模言語モデル(LLM)です。 従来のJanusモデルの強化版です。

現在、このモデルには2つのバージョンがあります。(Janus-Pro-1BとJanus-Pro-7B)この2つのバージョンで、さまざまなユースケースに対応できるようです。

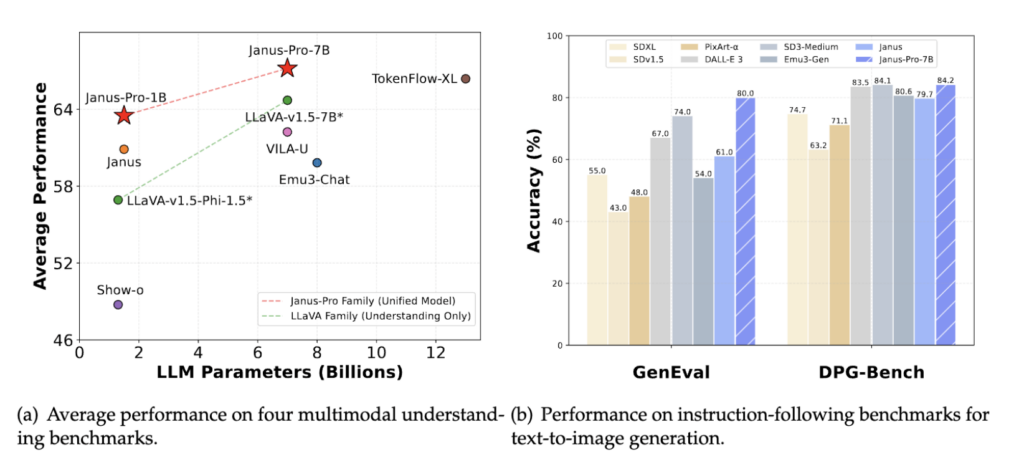

技術面については、公式のHuggingFaceによると、Janus-Proは、視覚情報を処理する際に役割を分けた「デカップリング」というアプローチを採用しているのが特徴です。この技術により、画像の理解と生成の両方を1つのモデルで効果的に実現しています。

さらに、視覚エンコーダー「SigLIP-L」を搭載し、最大384×384ピクセルの画像入力に対応。画像生成には、軽量で高速なトークナイザーを採用しているとのことです。

Janus-Proの詳しいトレーニングプロセスや、仕組みについて知りたい方は、DeepSeekの公式レポートを確認してみてください。

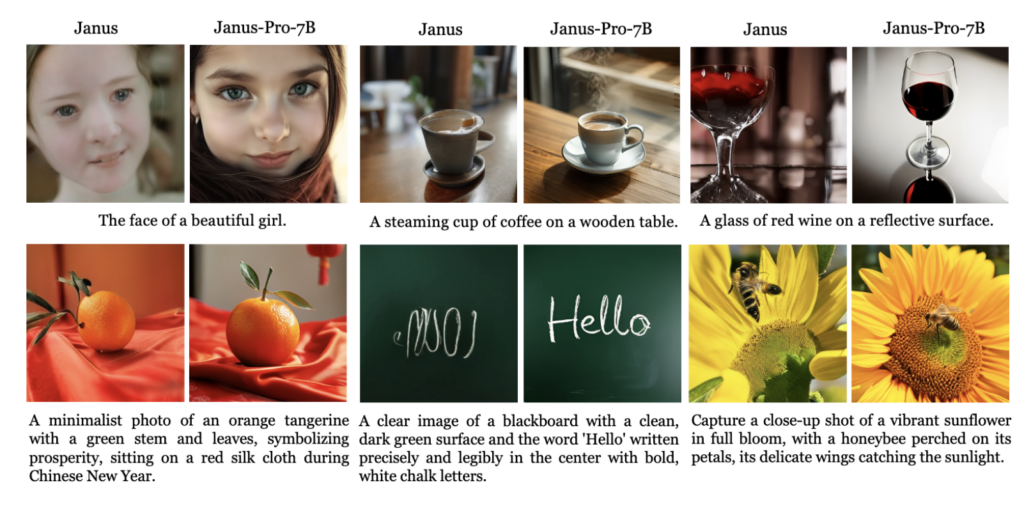

性能比較①:パラメータ

Janus Proモデルは、20種類のベンチマークで厳密にテストされ、その結果は以下の通りです。

テキストから画像への生成

- GenEval: スコアは0.80で、『DALL-E 3』(0.67)と『Stable Diffusion 3 Medium』(0.74)を上回った。

- DPG-Bench: 総合的な精度は84.19を達成し、濃密でニュアンスの異なるプロンプトを処理する能力が浮き彫りになった。

マルチモーダル理解

- MMMU(マルチモーダル機械理解): 41.0の精度を達成し、TokenFlow-XL(38.7)を上回った。

- MME (Multimodal Evaluation): 推論と文脈理解において著しい向上を示した。

性能比較:Dall-EやMidjourney、Imagenと比較

DeepSeekのJanus Pro 7Bと、OpenAIのDALL-EやMidjourney、GoogleのImagenと比較してみましょう。

Janus Pro 7Bはこちらから利用することが可能です。

※DALL-E3はChatGPTに搭載されているもの、MidjourneyはV6.1、ImagenはImageFX上で使用しているImagen3を使用しています。また、Janus Pro 7Bについては、デフォルトの設定のまま使用しています。

リアルな画像の精度

まずは、リアルなライオンの画像を作らせてみました、プロンプトはこちらです。

A hyper-realistic image of a lion in the savanna during sunset. The lion is majestic with a golden mane, standing on a slightly elevated patch of grass, surveying its surroundings. The background shows a vast savanna landscape with acacia trees, distant mountains, and a warm, glowing orange sky. The lion's fur and muscles are intricately detailed, emphasizing its strength and grandeur.

ライオンという学習が多くされているプロンプトなので、どのAIでもかなりきれい作れていますが、むしろJanus Pro 7Bだけ少し画質が低そうです。設定がデフォルトのままのせいかもしれませんが、他のAIと条件は等しいので、実用面では精度が低いように感じます。

日本人素材の精度は?

学習量が少なく、精度高く作ることが難しい日本人素材。Janus Pro 7Bではどうでしょうか?

以下のプロンプトで作ってみました。

A realistic photo of a Japanese woman in her 40s, with shoulder-length black hair and a confident, friendly expression. She is dressed in modern, stylish casual wear such as a blouse and blazer. The setting is a bright indoor environment with soft natural lighting and a neutral background. The overall atmosphere is professional yet approachable.

Janus Pro 7Bだけダントツで精度が低い結果となりました。その中でも、Imagenの精度は頭抜けて高いですね。

現状、日本人素材を作る場合はImagenが最も良さそうです。

アニメ風画像の精度は?

続いて、アニメ画像の精度を見てみましょう。

以下のプロンプトで作ってみました。

Retro-futuristic anime illustration: Japanese girl with pink twin tails and her black cat in a spaceship. Both wearing avant-garde outfits with iridescent helmets. Interior features geometric patterns and holographic displays. Background shows alien landscape with twin suns, pastel colors of lavender, mint and sky blue. Cinematic lighting with soft reflections.

こちらも、Janus Pro 7Bだけが精度が低い結果となりました。顔が潰れてしまっています。

特にMidjourneyとImagenについては、アニメの画風は違えど、プロンプトを精度高く表現できています。

画像の読み取り精度

続いて、画像の読み取りとその説明をさせてみましょう。こちらは、MidjourneyやImagenには存在しないので、DALL-E(ChatGPT-4o)とだけ比較します。

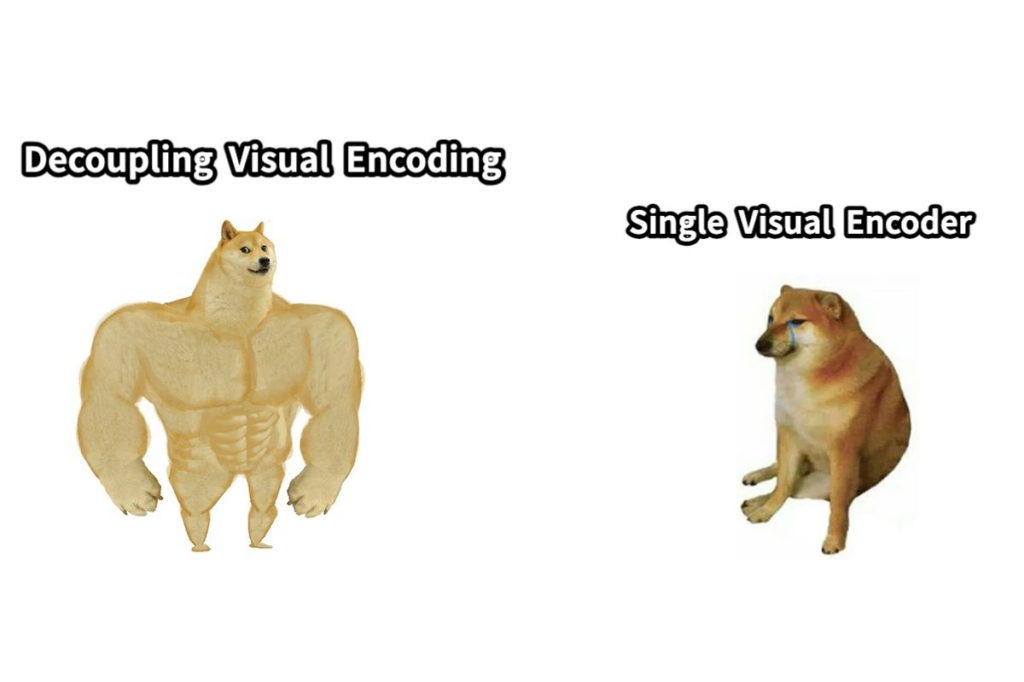

比較するのは、DeepSeekが実例として出しているものを使ってみます。

Janus Pro 7Bの回答

このミームは、「視覚エンコーディング」と「独自の視覚エンコーディング」という2つのポイントを示しています。左の犬は「視覚エンコーディング」というポイントに対して、肌肉が強く、立ち向かっている犬のイラストレーションを示しています。右の犬は「独自の視覚エンコーディング」というポイントに対して、ショッピングされた犬のイラストレーションを示しています。これらの犬は、視覚エンコーディングと独自の視覚エンコーディングの違いを表しています。

ChatGPTの回答

このミームは、視覚エンコーダーに関する2つの異なるアプローチを対比したものです。左側は「Decoupling Visual Encoding(視覚エンコーディングの分離)」と呼ばれる方法で、筋肉ムキムキのDogecoinの犬(Shiba Inu)が描かれており、強力で効率的であることを象徴しています。一方、右側は「Single Visual Encoder(単一視覚エンコーダー)」と呼ばれる方法で、泣いている弱々しい犬が描かれており、パフォーマンスや効率が低いことを示唆しています。 このミームは、おそらく視覚エンコーダー技術やモデルアーキテクチャの違いを皮肉ったり、ジョークにしたりするためのもので、分離された(独立した)視覚エンコーディングのほうが、単一のエンコーダーに比べて優れているという考えを表しています。技術的な文脈では、分離型のアプローチが柔軟性やスケーラビリティの面で優れていることをアピールしている可能性があります。

どうでしょうか?

Janus Pro 7Bもしっかり説明できてはいますが、ChatGPT-4oのほうが説明の精度は高いですね。

“皮肉”という言葉や、”筋肉ムキムキ”など、日本人に慣れ親しんだ表現ができているので、ChatGPTに軍配があがりそうです。

結論:Janus Proの精度はそこまでではない

世界に衝撃を与えたDeepSeekですが、画像生成AIとしての精度は、まだ最先端とは言えないことがわかりました。

ただ、これだけのモデルを、

- 少ない学習データから

- 少ない費用

- 少ない学習期間

で作ったとするならば、かなり驚異的です。DeepSeek R1の精度からしても、Janus Proの精度が高くなるのは時間の問題でしょう。

OpenAIが発表した動画生成AIモデル「Sora」も、ユーザーが使うには1動画あたり約40円近くかかります。それが、DeepSeekのような企業が出てくると、もっと速いスピードで安くなるかもしれません。

2025年も、生成AIの進化から目が離せないですね。

romptn aiが提携する「SHIFT AI」では、AIの勉強法に不安を感じている方に向けて無料オンラインセミナーを開催しています。

AIを使った副業の始め方や、収入を得るまでのロードマップについて解説しているほか、受講者の方には、ここでしか手に入らないおすすめのプロンプト集などの特典もプレゼント中です。

AIについて効率的に学ぶ方法や、業務での活用に関心がある方は、ぜひご参加ください。

\累計受講者10万人突破/