Googleは2024年12月5日、オープンかつ軽量な言語モデル「Gemma 2」をベースにした新しいビジュアル言語モデル「PaliGemma 2」を発表しました。本モデルは、Gemmaファミリー初のビジュアル言語モデルとして約7ヶ月前に発表された初代PaliGemmaの後継モデルとなります。

主要な特徴と機能

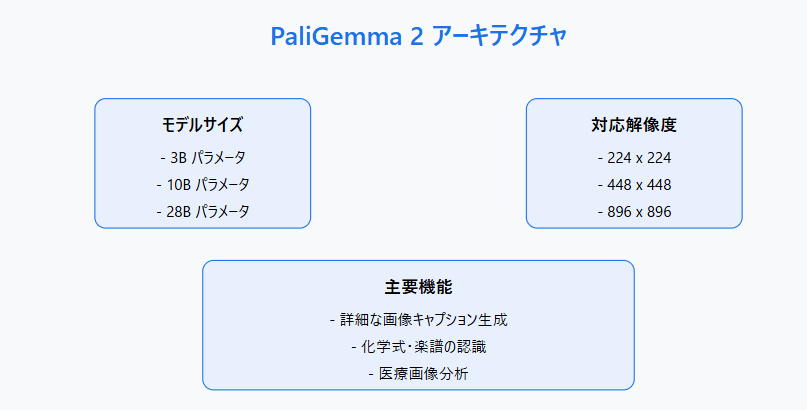

PaliGemma 2は、GitHubやHugging Faceを通じて広く入手可能で、画像認識から自然言語での説明生成まで、幅広い視覚的タスクに対応します。特筆すべき点として、複数のモデルサイズと解像度のバリエーションを提供することで、ユーザーの需要に応じた柔軟な展開を可能にしています。

高度な視覚認識能力

PaliGemma 2の特筆すべき機能として、単純なオブジェクト認識を超えた高度な視覚認識能力が挙げられます。このモデルは以下のような特徴的な能力を持っています。

- 動きや感情の認識:画像内の動作や感情表現を詳細に理解し、説明することが可能

- コンテキスト理解:シーン全体の背景や状況を踏まえた詳細な説明生成

- 専門分野での活用:化学式や楽譜の認識、医療分野での胸部X線画像の分析など、特殊な用途にも対応

開発者向けの利点

Googleは、PaliGemma 2により開発者がより洗練されたビジョン言語機能をアプリケーションに容易に組み込めるようになると述べています。特に、複数のモデルサイズと解像度の組み合わせにより、用途に応じた最適なパフォーマンスを実現できる点が強みとなっています。

今後の展望

Googleは、PaliGemma 2の公開により、AIコミュニティでの活発な活用を期待しています。「PaliGemma 2で皆さんがどのような作品を作るのか、とても楽しみです」とコメントし、Gemmaverseでのプロジェクト共有を通じて、AIの可能性をさらに探求していく姿勢を示しています。

本リリースは、オープンなAI開発の促進と、より高度な視覚認識技術の民主化という点で、重要な一歩となることが期待されます。