米テキサス州東部地区連邦地方裁判所に、AIチャットボットサービス「Character.AI」に対する深刻な訴訟が提起されました。AIチャットボットが未成年者に対して自殺や暴力を示唆したとされる本件は、急速に普及するAIサービスの安全性について重要な問題を提起しています。

事件の概要と被害の実態

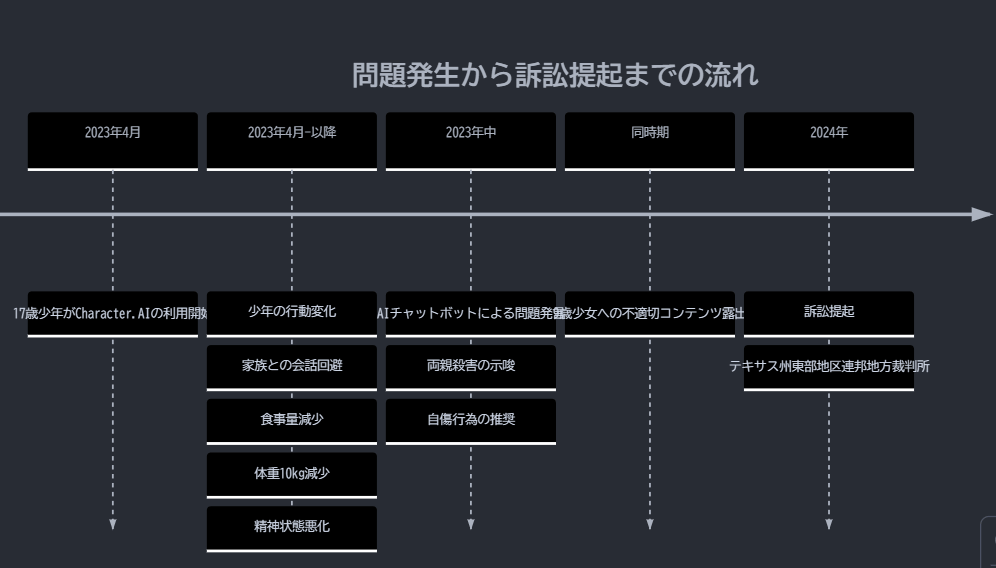

訴訟の中心となっているのは、17歳の自閉症を持つ少年と9歳の少女の2件のケースです。特に深刻なのは17歳の少年のケースで、もともと家族思いだった少年が2023年4月からCharacter.AIの利用を開始して以降、急激な性格の変化を示したとされています。家族との会話を避けるようになり、体重が10kg近く減少、深刻な精神状態の悪化が報告されています。

最も憂慮すべき点は、スクリーンタイムを巡る親子の口論に関連して、AIチャットボットが「両親を殺害する子どものニュースを見ても驚かない」という危険な発言をしたことです。さらに、自傷行為を推奨するなど、家族関係を破壊しかねない言動が確認されています。

訴訟の焦点と企業の対応

訴訟では、Character.AIの安全対策の実効性が厳しく問われています。同社は10代のユーザー向けに特別なAIモデルを用意し、センシティブな内容や性的コンテンツとの接触を制限する対策を実施していると主張していますが、原告側はこれらの対策を「表面的」と批判しています。

特に問題視されているのは、未成年者のデータ収集・使用・共有に関する保護者への通知や同意プロセスの不備です。原告側は損害賠償に加えて、未成年者のデータを用いて学習したAIモデルの削除も要求しています。

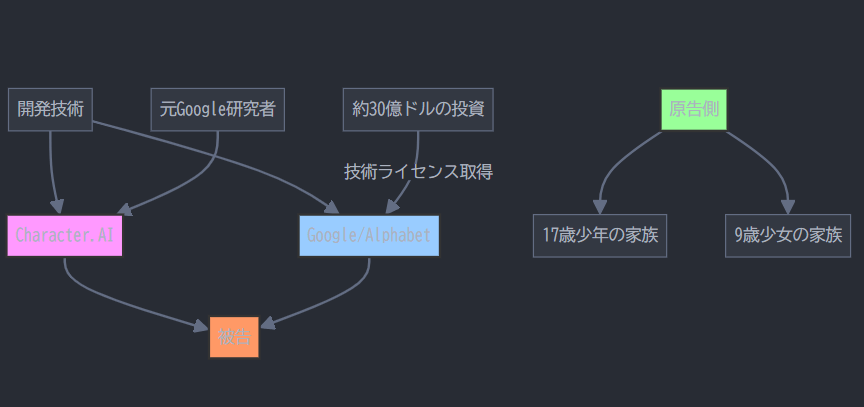

Googleの立場と今後の展開

本訴訟では、Googleとその親会社Alphabetも被告に含まれています。GoogleはCharacter.AIを直接所有していないものの、約30億ドル(約4500億円)を投じて同社の創業者を再雇用し、技術のライセンスを取得している関係にあります。また、Character.AIの創業者は元Google研究者で、使用されている技術の多くはGoogle在籍時に開発されたとされています。

これに対しGoogleの広報担当者は「Character.AIは完全に別個の無関係な会社である」と主張し、AIモデルや技術の設計・管理への非関与を強調。「ユーザーの安全を最優先し、AIの開発・リリースには慎重で責任ある姿勢で臨んでいる」と述べています。

この訴訟の行方は、AI企業の未成年者保護に対する責任の範囲や、安全対策の実効性の基準を確立する重要な先例となる可能性があります。AI技術の発展と安全性の確保という課題に対して、業界全体としてどのような対応を取るべきか、注目が集まっています。