Claudeを使っていて「この会話は、AIに学習データとして使用されるのだろうか」と不安に感じたことはありませんか?

特に個人情報や機密情報を扱う場面では、情報漏洩や悪用のリスクを懸念される方も多いでしょう。

そこで本記事では、以下のポイントをわかりやすく解説します。

- Claudeは会話を学習データとして利用するか、ユーザーが選択できる

- 会話内容が学習に利用される例外のケース

- Claudeをより安全に利用するためのポイント

- 他の生成AIとClaudeのデータ学習についての違い

この記事を読むことで、Claudeの会話に関する学習利用の疑問が解消され、業務でも安心して利用できるはずです。

📖この記事のポイント

- Claudeで会話を学習に利用するかはユーザーが選択できる

- 学習利用を拒否しても、例外の場合はモデル改善に使用される

- 他の生成AIと比較してもClaudeのデータ利用の透明性は高い

- Claudeを安心して活用するためのポイントを学ぶなら、まずは無料AIセミナーで最新のAI活用法を体験

- SHIFT AIの無料セミナーならAIのプロから無料で収入に直結するAIスキル習得から仕事獲得法まで学べる!

- 今すぐ申し込めば、超有料級の12大特典も無料でもらえる!

\ 累計受講者10万人突破 /

無料AIセミナーを見てみるClaudeの会話を学習に利用するかをユーザーが選択可能に

消費者規約とプライバシーポリシーの改訂に伴い、学習データとしての使用可否をユーザーが選択可能になりました。

今までClaudeでの会話は、入力データも出力データも学習データとして利用されませんでした。

開発元であるAnthropicが、ユーザーデーターを学習に使用しないと公式で明言していたためです。

しかし、有害な使用に対する保護強化を行い、Claudeの性能をさらに向上させて便利にすることを目的に規約が改訂されました。

改定が適応される対象は、Claude FreeとPro、Maxプランを使用しているユーザーです。加えて、上記プランに紐づけられたアカウントからClaude Codeを使用する場合も含まれます。

設定と変更はいつでも可能

使用可否の設定と変更は、新規ユーザー、既存ユーザー共にいつでも容易に行えます。

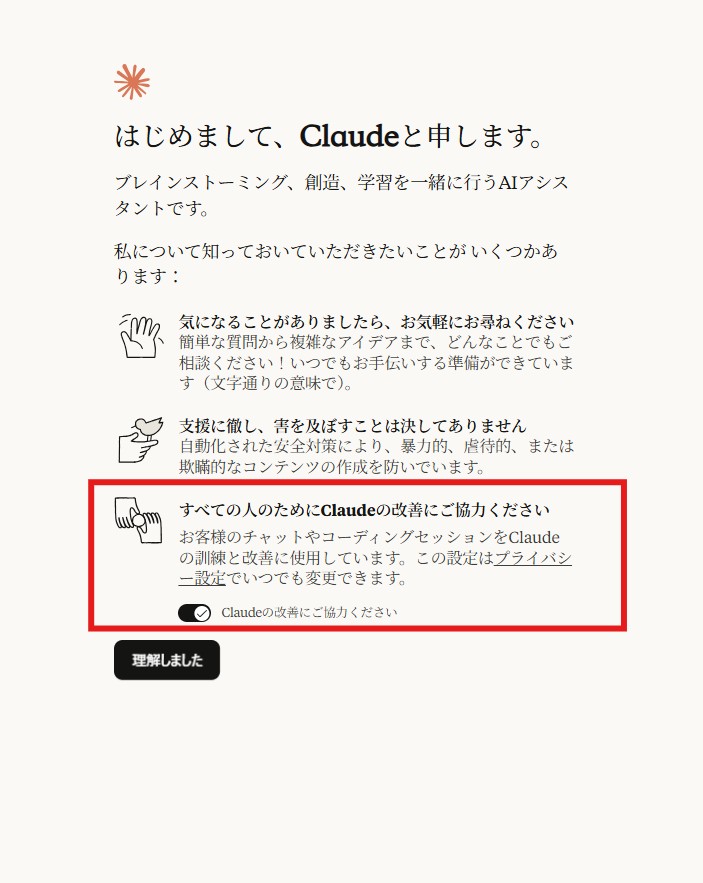

新規ユーザーはGoogleかメールアドレスでサインアップした後に、下記画面の赤枠部分で選択します。迷った際は一旦どちらかに設定しておき、後で変更することが可能です。

Anthropic公式サイトより

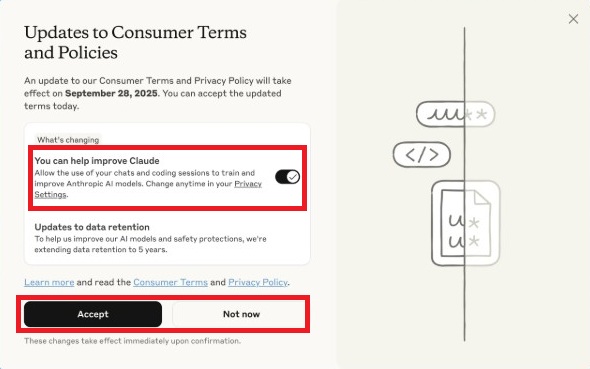

既存ユーザーは、ログインした際に下記のポップアップウィンドウが表示されるため、チェックで選択します。

今すぐ決められない場合は「Not Now」を選択し、新規ユーザー同様に後で決めることも可能です。

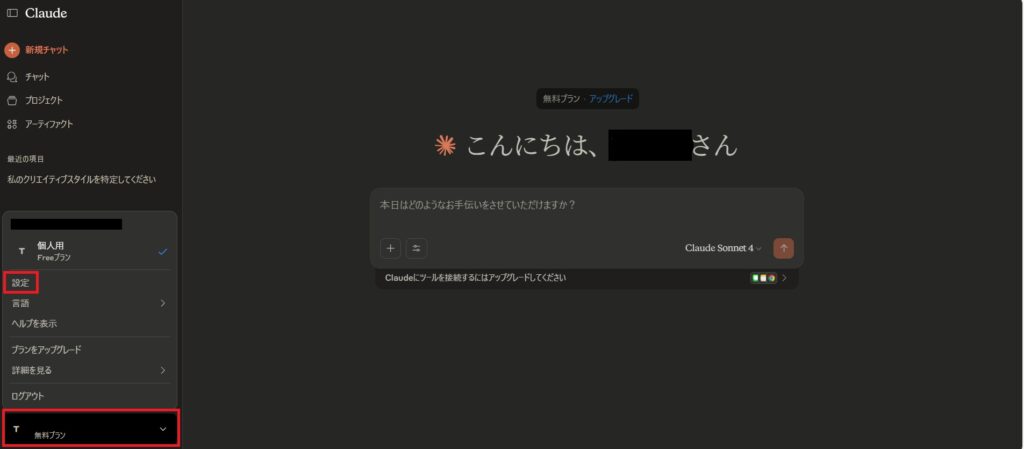

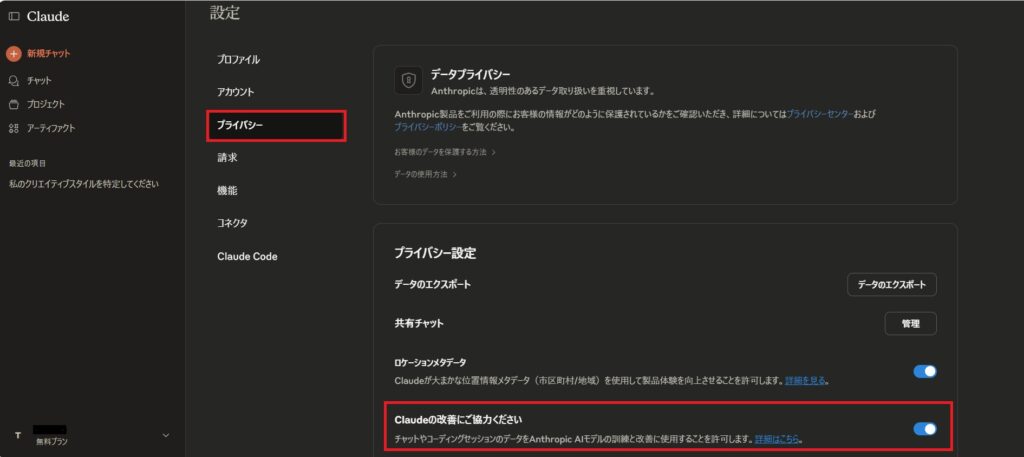

ここで、後から設定する方法を説明します。プライバシー設定の画面から行うため、画面右下のアカウントが表示されている部分を選択し、「設定」を開いてください。

そして、プライバシーを選択し最下部の赤枠「Claudeの改善にご協力ください」の部分で、許可するかしないかを選びます。

この設定はいつでも変更できますが、注意点として、2025年9月28日以降にClaudeを使用する際は、設定が不可欠です。

学習データとしての利用を許可した場合は、新規会話と再会した会話、コーディングセッションで設定が反映されます。

データ保持期間が5年に延長

改定に伴い、データ使用を許可した場合は、データ保持期間が30日間から5年間に延長されます。

延長の対象は設定が反映される対象と同様に、新規会話と再開した会話、コーディングセッションのみです。また、出力データに関するフィードバックも、5年間保持されます。

しかし、使用を許可しない場合や削除した会話、再開していない会話には非適応のため、保持期間は今まで通り30日間です。

会話内容が学習に利用される2つの例外ケース

学習データとしての使用を許可しない場合でも、下記の2ケースでは学習データとして使用されることがあります。

- ユーザーがフィードバックを送信した場合

- 規約や安全ポリシーに違反した場合

プライバシーポリシーにて、上記の場合は、データ使用を拒否していてもモデル改善にデータが使用されると明記しています。

以下にてわかりやすく説明するため、確認しておいてください。

①ユーザーがフィードバックを送信した場合

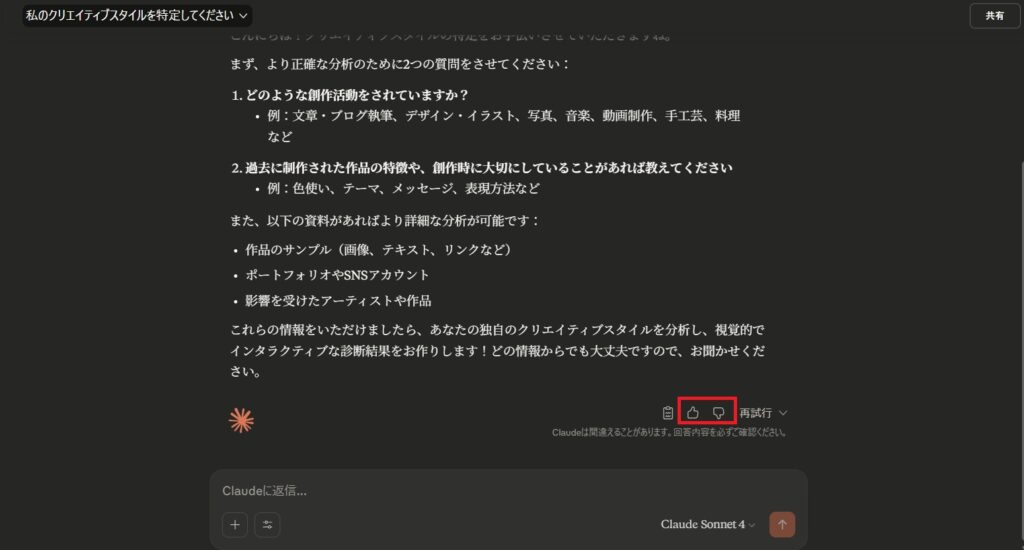

ユーザーの意志で送られたフィードバックは、サービス改善のための分析や調査、モデル訓練に利用されることがあります。Claudeの回答に対して、親指を上げる/下げるボタンから評価とコメントが送付できます。

機密情報を含む内容をそのままフィードバックしてしまうと、意図せず内部で保持・分析される可能性があるため注意が必要です。

安全に使うためには、フィードバック時に具体的な機密情報の入力を避けることが有効です。設定を問わず、フィードバックを送った場合はデータが使用されることを覚えておきましょう。

②規約や安全ポリシーに違反した場合

利用規約や安全ポリシーに反する可能性がある会話は、プラットフォームの健全性を保つ目的でレビュー・分析の対象になることがあります。

たとえば禁止行為や有害コンテンツなどが検出された場合、今後の不正利用を防ぐ目的や検出精度の向上のために、関連データが使われます。

これは一般的な日常利用を想定した処理ではなく、あくまで安全性違反の可能性がある場合の取り扱いです。普段から規約を守って利用していれば、この例外に該当するリスクは低く抑えられます。

Claudeをより安全に使うためのポイント

日常的にClaudeを安心して活用するために、すぐ実践できる「安全に使うためのポイント」を整理します。どれも難しくありませんが、継続して徹底することが大切です。

- 機密情報を入力しない

- 規約・ポリシーの変更通知は必ず確認する

- 組織での導入時はルールを策定する

①機密情報を入力しない

まず確実な対策は、Claudeに機密情報をそもそも入力しないことです。顧客名・個人を特定できる情報(氏名・住所・電話など)や社外秘情報、未公開資料などは避けましょう。

どうしてもClaudeでたたき台を作りたい場合は、社名を「A社」、人名を「Xさん」、コード・数値を伏せ字やダミー値に置き換えてください。画像データは機密部分が見えないよう加工するなど、マスキング(仮名化・匿名化)を徹底することが重要です。

マスキングの例

②規約・ポリシーの変更通知は必ず確認する

以前のClaudeにおけるデータ取り扱い方針は、基本的に「会話は学習に使わない」とされていました。しかし、最新(2025年9月2日時点)の方針では、ユーザーの選択に委ねられています。

細則やUIは更新されることがあるため、定期的な確認が必須です。アカウント通知や公式ヘルプ、プライバシーセンターの更新情報を定期的に確認し、変更点を把握しましょう。

特に「フィードバックの扱い」「セキュリティレビューの範囲」「データ保存と削除の手続き」などは、Claudeを利用する際の安心感につながります。

新しいトグルや説明が追加されていないか、Claudeのデータ・プライバシー設定ページも時々見直す習慣をつけることがおすすめです。

③組織での導入時はルールを策定する

チームや会社でClaudeを導入するでのあれば、共通ルールを先に決めると安全です。

たとえば入力禁止情報の定義とマスキング基準や、フィードバック送信時に機密情報を含めないこと、設定・ポリシー更新の定期確認担当者を決めるなどです。

Claudeの運用ルールをドキュメント化しておけば、人が入れ替わっても品質と安全性を保てます。

Claudeのその他のデータ利用ポリシー

ここでは、Claudeを安心して使うために、Anthropicの「データプライバシー」で明記されている要点を解説します。

- 会話を学習データとして使用するかは、ユーザーが選択できる

- ユーザーデータは第三者に販売されない

- リクエストに応じてデータを削除できる(安全性違反やフィードバック提出時を除く)

- 安全性違反と判定された会話は、安全性確保のため利用される場合がある

- メールアドレスは認証・請求処理・連絡・マーケティングに利用される

- 匿名化された利用データは集計分析に使われる

このように、基本的なデータの扱いは明確です。

利用状況の把握やサービス改善のために匿名化されたデータが分析され、学習データとしての使用はユーザーが選択できます。

利用者に見えない形で勝手に使われるのではなく、常に確認や制御ができる点が特徴です。

今すぐ無料参加!AI活用の最前線を学べる限定セミナー

AIの波に乗り遅れていませんか?多くの企業がAI導入で業績を伸ばす中、何も行動しなければ確実に取り残されます。

- ✅ 実践的なAI活用法が学べる

- ✅ 業界のプロから直接指導

- ✅ 参加者限定の特別12大特典プレゼント

- ✅ 完全無料・オンライン開催

▼今すぐ無料参加する▼

※席数限定のため、お早めにお申し込みください

他の主要生成AIとの比較(ChatGPT・Gemini・Grok)

Claudeはデータを学習させるかユーザーに選択肢を与えていますが、他社は方針や設定の仕組みに違いがあります。

最後に、ChatGPT(OpenAI)/Gemini(Google)/Grok(xAI)の公式ポリシーをもとに、それぞれの違いを解説します。導入の判断や運用ルールづくりの参考にしてください。

| Claude | 学習に利用するかユーザーが選択。いつでも変更可能。 (例外:フィードバック送信、安全性審査) |

| ChatGPT | 個人向けはデフォルトで学習に利用。設定でオフにできる。 ビジネス向けはデフォルト不使用。 |

| Gemini | Gemini Apps Activityがオンの間は改善・訓練に利用。オフで抑制。 (72時間の保存やレビュー済みの保持など例外あり) |

| Grok | ユーザー入力をサービス改善等に利用し得る旨を明記。 X上での利用はXのポリシーが適用。 |

- ChatGPT(OpenAI)

個人向けのChatGPTは、会話がモデル改善に使われるのがデフォルトです。ユーザーは任意で、学習利用を停止(オプトアウト)できます。

一方ChatGPT Team/Enterprise/APIなどビジネス向けはデフォルトで学習に不使用となっています。Temporary Chats(テンポラリーチャット)は、学習に使われず30日で削除されます。 - Gemini(Google)

Gemini Apps Activity(18歳以上は既定でオン)がオンの間、会話やアップロード内容は人によるレビューを含め、Googleのサービス改善(生成AIモデルの訓練を含む)に使用されます。Gemini Apps Activityをオフにすると、その後の会話は訓練に使われません。※

音声・動画・画面共有を含むGemini Liveの録音は別設定で、既定はオフになっておりユーザーがオンにすると改善目的で使用されます。

Activityがオフでも一時的にデータは保存されるため、フィードバックも含めて機密情報を入力しないよう徹底しましょう。

※(提供のため最大72時間の保存あり、送信したフィードバックやレビュー済みデータは最長3年保持) - Grok(xAI)

xAIのプライバシーポリシーでは、ユーザーが入力するコンテンツを「サービスの提供・分析・改善・研究」のために使用し得るという旨が示されています。

さらに公開X(旧Twitter)投稿や検索結果などの公的データをモデルの開発・改善に利用することも明記されています。

共有や公開リンクの扱いに注意し、個人情報や社外秘の入力を避けるのが安全です。GrokモバイルアプリやGrok.comのWEBサイト上で、データを学習に使用させるかどうかを選択できるようになっています。

このように、Claudeは学習に利用するか、例外や保存期間を公式にわかりやすく示しています。ChatGPT・Gemini・Grokといった他のAIと比較してもデータ利用の点でかなり透明性が高いといえます。

まとめ:Claudeを安心して使うために押さえるべきこと

この記事をまとめると、

- Claudeはデータを学習に利用するか、ユーザーが選択する

- 例外は2つだけ:①ユーザーが送るフィードバック、②安全性違反の可能性でフラグされた会話

- 機密情報は入力しない/フィードバックする場合にも機密を書かない運用が安全

- 他AIと比較してもClaudeはデータ利用に関する透明性が高い

でした。

Claudeは、学習データに使用するかユーザーが選択できるようになり、詳細も明確なため実務に取り入れやすい設計です。とはいえリスクがゼロになったわけではありません。

機密情報の線引きとフィードバック運用、そして設定・ポリシーの定期チェックを習慣化することで、Claudeをより安心して活用できるでしょう。

romptn aiが提携する「SHIFT AI」では、AIの勉強法に不安を感じている方に向けて無料オンラインセミナーを開催しています。

AIを使った副業の始め方や、収入を得るまでのロードマップについて解説しているほか、受講者の方には、ここでしか手に入らないおすすめのプロンプト集などの特典もプレゼント中です。

AIについて効率的に学ぶ方法や、業務での活用に関心がある方は、ぜひご参加ください。

\累計受講者10万人突破/